¿Lunar o cáncer? El algoritmo que se equivoca en uno de cada tres melanomas y obvia a los pacientes con la piel oscura

El País Vasco trabaja en la implantación de Quantus Skin en sus centros sanitarios tras una inversión de 1,6 millones de euros. Los especialistas critican el sistema de inteligencia artificial de una filial de Asisa por sus resultados "pobres" y "peligrosos". El algoritmo está entrenado solo con pacientes blancos.

El tiempo es oro. Especialmente si hablamos de melanoma, el cáncer de piel más peligroso: diagnosticar cuanto antes este tumor resulta decisivo para salvar vidas, más que en casi cualquier otro cáncer. En España, se estima que en 2025 habrá cerca de 9.400 casos de melanoma, un tumor muy agresivo, que puede diseminarse rápido y causar metástasis en apenas unos meses. Cuando esto ocurre, el pronóstico suele ser malo, por lo que cualquier error en la detección puede resultar fatal.

Precisamente esta urgencia ha llevado al País Vasco a apostar por la inteligencia artificial. El Servicio Vasco de Salud, Osakidetza, trabaja para que sus centros de salud y hospitales públicos incorporen Quantus Skin, un algoritmo diseñado para diagnosticar el riesgo de cáncer de piel, incluido el melanoma. En teoría, promete agilizar el proceso: desde atención primaria, las médicas y médicos de familia podrán enviar al servicio de dermatología del hospital imágenes de lesiones sospechosas, junto con la probabilidad de que sean malignas, calculada de forma automatizada por el algoritmo. La idea del Gobierno vasco es que Quantus Skin, actualmente en pruebas, ayude a decidir qué pacientes deben ser atendidos primero.

Un contrato público de 1,6 millones de euros en manos de Asisa

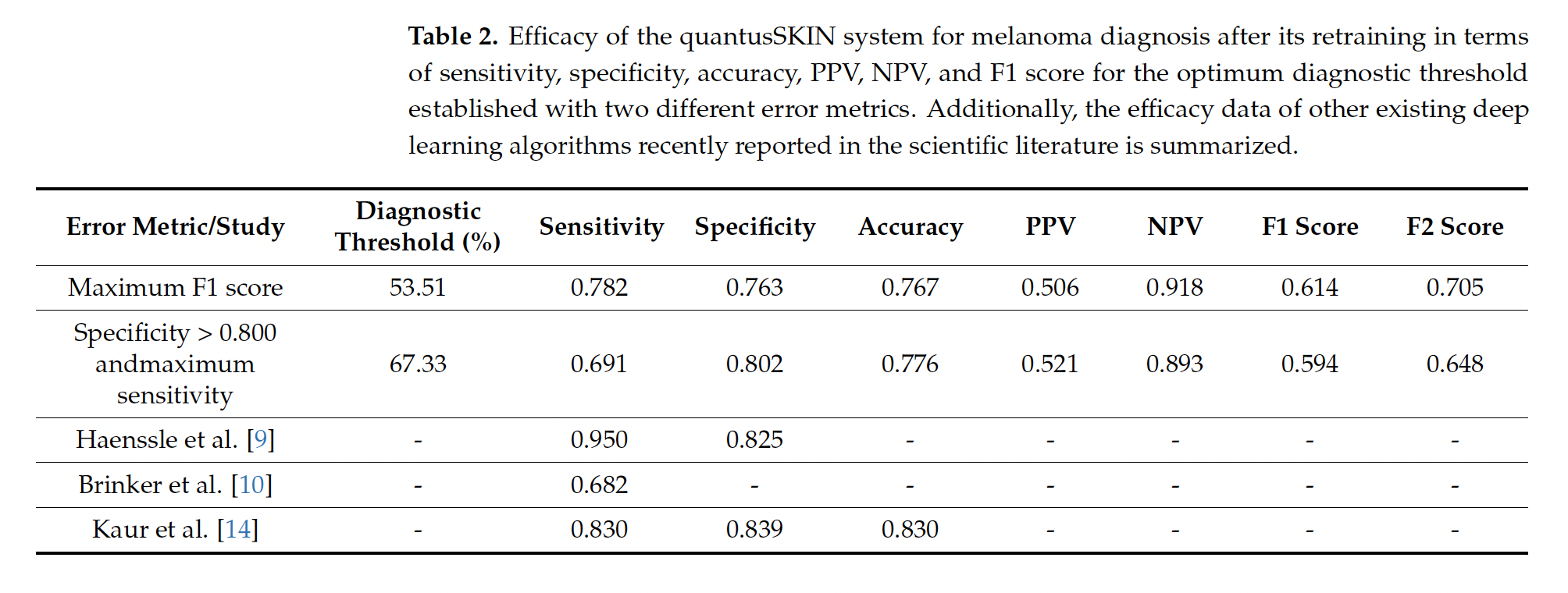

En 2022, Osakidetza adjudicó un contrato de casi 1,6 millones de euros a Transmural Biotech para poner en marcha “algoritmos de inteligencia artificial en imagen médica”, exigiendo una sensibilidad y especificidad del 85% “como mínimo”. La empresa, spin-off de la Universitat de Barcelona y del Hospital Clínic, pertenece a la aseguradora privada Asisa. Según Osakidetza, pese a que los pliegos recogían varios algoritmos, finalmente se eligieron solo dos, incluido Quantus Skin, por su “mayor impacto asistencial” y por su “mayor rendimiento en salud”. Como ha podido saber Civio, la decisión se tomó de forma unilateral, sin consultar con los especialistas correspondientes. En febrero, Osakidetza también aseguró que Quantus Skin había superado “las fases de validación” y estaba “en fase de integración”. En respuesta a las preguntas de Civio sobre su eficacia clínica, ahora afirma que continúa en pruebas y que tomará decisiones “en función de los resultados obtenidos”. No obstante, evita contestar si conocía que los datos publicados de eficacia clínica de Quantus Skin (69,1% de sensibilidad y 80,2% de especificidad) estaban por debajo del umbral del 85% que exige el contrato. Aparte de la adjudicación en el País Vasco, Transmural Biotech solo tiene otro contrato público, en Cataluña, por un importe mucho menor (25.000 euros) para certificar algoritmos de inteligencia artificial en radiología.

Sin embargo, los datos muestran una realidad preocupante. Transmural Biotech, la empresa que comercializa Quantus Skin, llevó a cabo un estudio inicial con resultados prometedores, pero que tenía importantes limitaciones: se hizo completamente online y no se publicó en ninguna revista académica, es decir, no pasó el control de calidad habitual que se exige en ciencia.

Más adelante, dermatólogos del Hospital Ramón y Cajal de Madrid y profesores de la Universidad Complutense realizaron un segundo estudio, que sí fue publicado, para evaluar la eficacia clínica real de Quantus Skin. Este trabajo, que contó con financiación y asistencia técnica de Transmural Biotech, mostró peores resultados: el algoritmo pasa por alto uno de cada tres melanomas. Su sensibilidad es del 69%, lo que significa que deja escapar el 31% de los casos reales de este cáncer potencialmente letal.

Preguntado por Civio sobre el segundo estudio, el director general de Transmural Biotech, David Fernández Rodríguez, responde por correo de forma evasiva: “No sé ahora mismo cuál es”. Tras insistir por teléfono, cambia de versión: “Lo que estábamos haciendo eran pruebas” para detectar posibles problemas de implementación. Y, al final de la llamada, Fernández Rodríguez reconoce que Quantus Skin “no es que dejara de funcionar, funcionaba bastante peor, pero nos teníamos que dar cuenta por qué”.

El director general de Transmural Biotech atribuye estos peores resultados a deficiencias en la toma de imágenes por no seguir las instrucciones de Quantus Skin. Es algo que han visto también en las pruebas del País Vasco: “Los médicos de primaria no están entrenados bien para coger las imágenes”, según dice, lo que apunta la necesidad de “formar a los médicos”. Sin embargo, en el segundo estudio participaron dermatólogos, especializados precisamente en fotografiar lesiones sospechosas para luego diagnosticarlas. Según Fernández Rodríguez, la fiabilidad mejoró tras “recortar bien las imágenes” porque “no estaban cumpliendo exactamente” las instrucciones.

Un sistema criticado por fuentes independientes

“Para cáncer de piel”, tener una sensibilidad del 70% “es muy malo. Es muy pobre. Si tú le das esto a alguien para que haga una foto, te diga si puede ser un melanoma y se equivoca en uno de cada tres, no es adecuado para un cribado de cáncer de piel en un entorno de primaria, tienes que pedirle más”, explica a Civio el doctor Josep Malvehy Guilera, director de la Unidad de Cáncer cutáneo del Hospital Clínic de Barcelona. Para la doctora Rosa Taberner Ferrer, dermatóloga en el Hospital Son Llàtzer de Mallorca y autora de Dermapixel, “un 31% de falsos negativos suena cuanto menos peligroso. Como cribado es una castaña”.

Sin embargo, el director general de Transmural Biotech intenta minimizar el problema enfocándose solo en los datos que favorecen a su producto, evitando hablar de la baja sensibilidad de Quantus Skin. Según el mismo trabajo que analizó su eficacia clínica, el sistema falla además por partida doble: su especificidad implica un 19,8% de falsos positivos, es decir, confunde uno de cada cinco lunares benignos con melanoma. Esto supondría que el uso de Quantus Skin aconsejaría derivar innecesariamente a casi el 20% de las personas atendidas.

En el estudio, los autores —dermatólogos del Hospital Ramón y Cajal de Madrid y profesores de la Universidad Complutense de Madrid— defienden que es preferible que Quantus Skin tenga una alta especificidad (pocos falsos positivos) aunque sea a costa de una baja sensibilidad (más falsos negativos) ya que no se aplicará para diagnosticar con certeza, sino como cribado, es decir, para ayudar a filtrar casos desde atención primaria. Según su hipótesis, así se puede evitar que las consultas especializadas se saturen y bajar las listas de espera y los gastos médicos asociados.

“Si se equivoca haciendo diagnóstico de melanoma en lesiones con un riesgo potencial de crecer rápidamente y poder incluso causar la muerte del paciente, ahí tengo que ser muy poco tolerante. Ya tengo que pedir sensibilidades del 92, 93, 94% como mínimo”

Los especialistas consultados por Civio cuestionan la estrategia detrás del algoritmo. Aunque no existe un estándar ideal para el diagnóstico de cáncer —en parte porque depende de la agresividad de cada tumor—, lo conseguido por Quantus Skin está lejos de ser aceptable. “Si se equivoca haciendo diagnóstico de melanoma en lesiones con un riesgo potencial de crecer rápidamente y poder incluso causar la muerte del paciente, ahí tengo que ser muy poco tolerante. Ya tengo que pedir sensibilidades del 92, 93, 94% como mínimo”, dice Malvehy Guilera.

“Si pretenden utilizarlo como cribado, entonces el sistema debería tener una sensibilidad súper alta a expensas de una especificidad un poco más bajita”, explica Taberner Ferrer. En otras palabras, es preferible que un algoritmo como este se pase de precavido: mejor errar un poco generando falsas alarmas en personas sanas que pasar por alto un caso real de cáncer.

Piel oscura, diagnóstico incierto

Los problemas de Quantus Skin van más allá de su baja sensibilidad. El trabajo solo evaluó la eficacia clínica en el diagnóstico de melanoma, pero no analizó otros tipos de cáncer de piel más frecuentes pero menos agresivos, como el carcinoma basocelular y el carcinoma de células escamosas, donde también se puede aplicar Quantus Skin. Los autores tampoco estudiaron cómo afecta el color de piel al funcionamiento del algoritmo, aunque reconocen que es una de las principales limitaciones de su investigación.

La diversidad que Quantus Skin no contempla

A principios de 2025, el País Vasco contaba con 316.942 personas de origen extranjero, según datos del Observatorio Vasco de Inmigración Ikuspegi. Más de 60.000 procedían del Magreb y del África subsahariana, mientras que cerca de 164.000 personas venían de Latinoamérica, donde existe una gran variabilidad de tonos de piel. Eso sin contar a las personas nacidas en España con ascendencia extranjera que residen en el País Vasco, como los conocidos futbolistas Iñaki y Nico Williams.

Quantus Skin, basado en redes neuronales, ha aprendido a reconocer el cáncer de piel casi exclusivamente en personas blancas. El algoritmo se alimentó primero con algo más de 56.000 imágenes de la International Skin Imaging Collaboration (ISIC), un repositorio público de fotografías médicas recopiladas principalmente por hospitales occidentales, donde la mayoría corresponden a pacientes con pieles claras. Posteriormente, Quantus Skin se probó usando imágenes de 513 pacientes del Hospital Ramón y Cajal de Madrid, todos ellos blancos.

El conjunto de datos con los que se alimentó Quantus Skin incluye imágenes “de varones y de mujeres caucásicas”, confirma el director general de Transmural Biotech. “No me quiero meter en el tema de minorías étnicas y todo esto, porque la herramienta la utiliza el País Vasco, la utiliza Osakidetza. Lo que pongo a disposición es una herramienta, con las limitaciones que tiene”, dice Fernández Rodríguez. Pese a la falta de entrenamiento en pieles más oscuras, el Gobierno vasco señala que no es necesario “implantar” ninguna medida “para promover la igualdad y la no discriminación”, según se recoge en la ficha de Quantus Skin que consta en el catálogo de algoritmos y sistemas de inteligencia artificial de Euskadi. Sin embargo, como las redes neuronales se han entrenado casi en exclusiva con imágenes de personas blancas, es probable que fallen más en pieles más oscuras, como individuos de etnia gitana o migrantes de Latinoamérica y África.

“Es muy fácil hacer que los algoritmos se equivoquen”

“Es muy fácil hacer que los algoritmos se equivoquen”, explica a Civio Adewole Adamson, profesor de dermatología en la Universidad de Texas, que ya advirtió en 2018 de la discriminación que podría conllevar la inteligencia artificial si no se desarrollaba de forma inclusiva y diversa, un problema que va más allá de Quantus Skin.

Sus predicciones se han confirmado. En dermatología, cuando los algoritmos se alimentan principalmente con imágenes de pacientes blancos, disminuye “la fiabilidad diagnóstica en pieles oscuras”, comenta Taberner Ferrer. El algoritmo Skin Image Search, de la compañía sueca First Derm, entrenado principalmente con fotos de pieles blancas, redujo su precisión del 70% al 17% cuando se probó en personas con piel oscura. Investigaciones más recientes han confirmado que este tipo de algoritmos funcionan peor en personas negras, algo que no se debe a problemas técnicos, sino a la falta de diversidad en los datos de entrenamiento.

Aunque el melanoma sea un cáncer mucho más frecuente en personas blancas, las personas con piel oscura tienen una supervivencia global bastante más baja. El ingeniero estadounidense Avery Smith conoce bien estas cifras. A su pareja, Latoya Smith, le detectaron un melanoma solo un año y medio después de casarse. “Me sorprendieron mucho las tasas de supervivencia según la etnia. Latoya, siendo afroamericana, estaba en la parte más baja. No lo sabía hasta que me golpeó como si me hubiera atropellado un autobús. Fue terrorífico”, cuenta a Civio. Un tiempo después del diagnóstico, a finales de 2011, Latoya murió.

Desde entonces, Avery Smith trabaja para lograr una dermatología más inclusiva y para que los algoritmos no amplifiquen las desigualdades. Para recordar el “impacto” que pueden tener, especialmente en grupos vulnerables, Smith rechaza hablar de la inteligencia artificial como una “herramienta”, como si fuera una simple “tijera”: “Es un término de márketing, una forma de hacer que la gente lo entienda. Pero es mucho más”.

De esos efectos habla también la jurista Anabel K. Arias, portavoz de la Federación de Consumidores y Usuarios (CECU): “A la hora de pensar en utilizarla para hacer diagnóstico temprano, puede haber una porción de la población que esté subrepresentada. En ese caso, el diagnóstico puede llegar a ser erróneo y tener un impacto en la salud de la persona. Se puede pensar incluso en un daño”.

Pacientes invisibles a ojos de un algoritmo

“Las personas tendemos a fiarnos mucho de la inteligencia artificial, le atribuimos unas cualidades de objetividad que no son reales”, dice Helena Matute Greño, catedrática de psicología experimental de la Universidad de Deusto. Cualquier IA utiliza la información que recibe para tomar decisiones. Si esos datos de entrada no son buenos o están incompletos, es posible que falle. Cuando se equivoca de forma sistemática, el algoritmo comete errores a los que llamamos sesgos. Y, en el caso de que afecten más a un determinado grupo de personas —por su origen, color de piel, género o edad— hablamos de sesgos discriminatorios.

Una revisión publicada en Journal of Clinical Epidemiology mostró que solo el 12% de los estudios sobre la IA en medicina analizaba si tenía sesgos. Y, cuando lo estudiaban, el sesgo más frecuente era el de tipo racial, seguido del de género y la edad, afectando en su gran mayoría a grupos que históricamente habían sufrido discriminaciones. Estos errores pueden ocurrir si los datos de entrenamiento no son suficientemente diversos y equilibrados: si los algoritmos aprenden solo de una parte de la población, funcionan peor en grupos diferentes o minoritarios.

Los errores no se limitan solo al color de piel. Las tecnologías comerciales de reconocimiento facial fallan mucho más al clasificar a mujeres negras porque históricamente se han entrenado con imágenes de hombres blancos. Algo similar ocurre con los algoritmos que analizan radiografías de tórax o que predicen enfermedades cardiovasculares, cuyo rendimiento diagnóstico es peor en mujeres si los datos de entrenamiento están desequilibrados. Por su parte, uno de los conjuntos de datos más utilizados para predecir enfermedades del hígado está completamente sesgado —el 75% corresponde a hombres—, por lo que los algoritmos que lo usan fallan mucho más en mujeres. En Reino Unido, el algoritmo para priorizar trasplantes discriminaba a las personas más jóvenes. ¿El motivo? Se había entrenado con datos limitados, que solo tenían en cuenta la supervivencia en los siguientes cinco años, y no toda la vida que podrían ganar los pacientes que recibieran un nuevo órgano.

“Los datos con los que se entrenan tienen que representar a toda la población donde luego se va a utilizar”, explica la doctora Nuria Ribelles Entrena, portavoz de la Sociedad Española de Oncología Médica (SEOM) y oncóloga del Hospital Universitario Virgen de la Victoria de Málaga. “Si solo lo entreno con un determinado grupo de pacientes, va a ser muy eficaz en ese grupo, pero en otro no”, añade.

Los sesgos de edad son especialmente problemáticos en pediatría. “Los niños no son pequeños adultos. Tienen una fisiología y unos procesos patológicos completamente diferentes”, advierte una revista especializada. Como normalmente no participan en investigaciones clínicas, la situación es “un drama”, según Antonio López Rueda, portavoz de la Sociedad Española de Radiología Médica (SERAM) y radiólogo del Hospital Universitario de Bellvitge en Barcelona.

Ignasi Barber Martínez de la Torre, portavoz de la Sociedad Española de Radiología Pediátrica (SERPE) y jefe de servicio de radiología pediátrica del Hospital Sant Joan de Déu, lo ilustra con una experiencia personal. Su equipo intentó validar en población infantil un modelo de radiografías del tórax entrenado en adultos. “Enseguida nos dimos cuenta que cometía muchos más errores. La sensibilidad y especificidad eran totalmente distintas”, cuenta. Uno de los errores era identificar como sospechoso el timo, una glándula muy grande en niños pequeños que desaparece en la etapa adulta. Lo mismo pasa con el esqueleto, que en los más pequeños tiene “partes no osificadas” que se pueden confundir con fracturas.

Evitar los sesgos, una carrera de obstáculos

La solución para evitar los sesgos existe: “El conjunto de entrenamiento tiene que ser lo más amplio posible”, explica López Rueda. Pero esto no siempre se puede verificar. Hasta ahora, la mayoría de sistemas de inteligencia artificial implementados en España que usan imágenes médicas no suelen publicar los datos de entrenamiento. Así ocurre con dos dispositivos de dermatología —de los que no conocemos ni el nombre— que se activarán primero en el área sanitaria del Caudal y luego se extenderán a todo el Principado de Asturias. Y también con la aplicación comercial ClinicGram, para detectar úlceras de pie diabético, incorporada en el Hospital Universitario de Vic (Barcelona); o con los distintos sistemas privados para radiología, como BoneView y ChestView o Lunit, que están funcionando en algunos hospitales de la Comunidad de Madrid, del Principado de Asturias y de la Comunidad Valenciana.

Cuando los conjuntos de datos sí son accesibles, otro obstáculo es que no recojan metadatos, como el origen, el género, la edad o el tipo de piel, que nos permitirían comprobar si son inclusivos y equilibrados. En dermatología, la mayoría de conjuntos de datos públicos no suelen etiquetar el origen de los pacientes ni su tono de piel. Cuando sí se incluye esta información, los estudios muestran sistemáticamente que la población negra está muy infrarrepresentada. “Cada vez se es más consciente del problema y los desarrolladores de algoritmos han intentado abordar estas deficiencias. Sin embargo, aún queda trabajo por hacer”, cuenta el profesor Adamson.

La calidad y cantidad de datos disponibles también condiciona lo bien que funcionen los algoritmos. “Lo que nos hizo mejorar nuestra eficiencia en cuanto a diagnóstico era que usábamos nuestros fondos propios de imágenes”, dice Julián Conejo-Mir, catedrático y jefe de servicio de dermatología en el Hospital Universitario Virgen del Rocío de Sevilla. El especialista se refiere a la inteligencia artificial que han desarrollado para el diagnóstico del cáncer de piel y para identificar la profundidad del melanoma, un parámetro que se relaciona con la agresividad de estos tumores.

Su base de datos, que integra imágenes de cerca de un millar de pacientes del hospital sevillano y fotografías de otros repositorios, ha servido para diseñar un algoritmo, actualmente en investigación, con un 90% de capacidad de acierto. Pero, hasta en sistemas aparentemente exitosos como este, es difícil entrenar los algoritmos para que reconozcan los casos menos frecuentes. Eso es precisamente lo que pasa con el melanoma acral lentiginoso, el cáncer de piel más frecuente en población negra y del que falleció Bob Marley cuando solo tenía 36 años. Este tumor es especialmente traicionero porque aparece en zonas donde no se suelen buscar lesiones sospechosas, como las palmas de las manos y de los pies o bajo las uñas, como le ocurrió a Marley.

Cada año, el servicio de dermatología del Hospital Universitario Virgen del Rocío de Sevilla diagnostica unos 150 casos de melanoma, de los que solo 2-3 son lesiones acrales. “Tuvimos que sacarlo del entrenamiento porque teníamos muy poquitos casos y, si lo uníamos al resto, fallaba; si lo separábamos, no teníamos un número suficiente de imágenes”, explica a Civio el doctor José Juan Pereyra Rodríguez, jefe de sección del Hospital Universitario Virgen del Rocío de Sevilla.

Esta inteligencia artificial, que no se usa para cribado clínico, sino con fines de investigación, no puede aplicarse en casos de melanoma acral lentiginoso porque no contaban con suficientes datos de este tipo de cáncer para entrenar el algoritmo de forma fiable. Para conseguirlo, hubieran necesitado unos “50 años”, según estimaciones de Pereyra Rodríguez. “En nuestro caso, es tan sencillo como decir: ojo, no uses el algoritmo para lesiones acrales, en general, porque no lo he entrenado. Ya está, es una limitación”, apunta.

“La teoría dice que si el 90% de mi población” corresponde a pieles blancas, “tengo que entrenar” con esos tipos “porque la prevalencia también es importante a la hora de tomar decisiones. Tengo que entrenar en mi entorno”, subraya Pereyra Rodríguez. En el caso de sistemas desarrollados fuera, lo ideal es que los hospitales evalúen el rendimiento de los algoritmos en sus propios grupos de pacientes. Algo que también defiende López-Rueda, quien aboga por hacer “un re-entrenamiento con los datos locales” antes de poner en marcha cualquier inteligencia artificial. “Es muy caro tanto para la empresa como para el hospital, pero eso es lo que realmente funcionaría”, sostiene el radiólogo.

“Los algoritmos sesgados privan a los pacientes de los beneficios potenciales de esta tecnología revolucionaria”

Incluso en España, las características de la población también varían en función del código postal. “Si yo desarrollo un software en el Hospital Clínic [en pleno centro de Barcelona] y lo implemento en Bellvitge [en el extrarradio], no me sirve. Y, si lo hago al contrario, tampoco”, afirma López-Rueda. Las consecuencias de los sesgos algorítmicos pueden ser realmente nefastas: que los pacientes puedan verse perjudicados por un diagnóstico incorrecto. “Los algoritmos sesgados privan a los pacientes de los beneficios potenciales de esta tecnología revolucionaria”, señala Adamson, quien apunta hacia la raíz del problema: “No está en los algoritmos, sino en la reflexión y el cuidado con que se diseñan y desarrollan”.

Metodología

Este es el primer artículo dedicado a sanidad de nuestra serie de transparencia algorítmica, pronto publicaremos nuevas informaciones sobre la situación en el Sistema Nacional de Salud. En esta investigación han colaborado Eva Belmonte y David Cabo, mientras que Ter García, Javier de Vega, Olalla Tuñas y Ana Villota han ayudado revisando el texto.

Civio ha confirmado la incorporación de los algoritmos y sistemas de IA citados en el artículo a través de diversas fuentes:

1) En el caso del País Vasco, mediante una solicitud de acceso a la información pública, vía Ley de Transparencia, y tres posteriores respuestas del Gabinete de prensa del Servicio Vasco de Salud (Osakidetza), aunque no han contestado a todas las preguntas formuladas por Civio sobre Quantus Skin. A partir de estos datos, hemos ampliado la información gracias al análisis de la documentación asociada al contrato adjudicado a Transmural Biotech y a la información disponible en el catálogo de algoritmos y sistemas de IA de Euskadi, así como a la prepublicación realizada por empleados de la empresa, subida a la plataforma medRxiv y que no ha sido publicada en ninguna revista científica (y, por ello, no ha sido revisada por pares) y al posterior artículo científico que evaluó la eficacia de Quantus Skin, llevado a cabo por dermatólogos del Hospital Ramón y Cajal de Madrid y profesores de óptica de la Universidad Complutense de Madrid, y publicado en la revista International Journal of Environmental Research and Public Health (MDPI). También hemos contrastado la información entrevistando al CEO de Transmural Biotech, que insistió durante llamada en una métrica que resulta favorable a Quantus Skin, conocida como valor predictivo negativo (VPN), un parámetro que no responde exactamente a la misma pregunta que la sensibilidad, sino que apunta a la probabilidad de que, si un test ha salido negativo, sea realmente negativo. Por su parte, como se explica en el artículo, la sensibilidad se centra en que saber si el sistema detectará a los pacientes que de verdad tengan melanoma. Es decir, son métricas que no se contradicen, sino que miden cosas diferentes. Asimismo, aunque desde la empresa ensalzan el estudio online, del que precisamente salen los datos que publican en su web, incluyendo el mencionado VPN, el propio trabajo dice que la evaluación, “utilizando imágenes en línea, no constituye un estudio clínico” y que los hallazgos deben validarse “en una población real”.

2) En el Principado de Asturias, aunque inicialmente el Gobierno autonómico resolvió nuestra solicitud de acceso afirmando que “actualmente no existe ningún sistema implantado en el ámbito de la salud que utilice inteligencia artificial”, posteriormente el Gabinete de prensa de la Consejería de Salud nos confirmó la reciente puesta en marcha de varios sistemas de radiología, así como la inclusión futura de dos dispositivos de dermatología.

3) En la Comunidad de Madrid, la Consejería de Digitalización inicialmente nos respondió asegurando que había siete proyectos de IA incorporados en el Servicio Madrileño de Salud, una cifra que tiempo después ascendió a 70, según confirmamos a través de una solicitud de acceso a la información pública. En el texto solo hacemos mención a algunos de estos sistemas, implantados en varios hospitales de la región.

4) En Comunidad Valenciana, cuya Consellería de Sanidad inicialmente resolvió nuestra solicitud de acceso asegurando que no habían tomado ninguna decisión sobre la incorporación de sistemas de IA, posteriormente confirmamos, gracias a GVA Confía, el Registro de algoritmos de la Generalitat, que sí hay tres dispositivos activos.

Para la realización de este reportaje, hemos buscado en la literatura científica, principalmente a través de PubMed, Google Scholar y de repositorios de prepublicaciones (preprints), como medRxiv, bioRxiv y arXiv. También hemos consultado informes de evaluación de tecnologías sanitarias, como este documento sobre la aplicación de IA en el cribado de cáncer de mama, libros especializados como este publicado por el CSIC, otros documentos especializados como este informe de la activista Júlia Keserű para la Fundación Mozilla y también hemos asistido a eventos como la jornada sobre IA y medicina organizada por la Federación de Asociaciones Científico Médicas Españolas (FACME). Asimismo, hemos consultado los pocos registros públicos existentes sobre algoritmos y sistemas de inteligencia artificial, como el puesto en marcha en el País Vasco o en la Comunidad Valenciana.

Junto con las fuentes documentales mencionadas, durante la investigación hemos contactado con múltiples fuentes expertas (además de las citadas en el texto), que nos han ayudado y a las que queremos agradecer su colaboración, como los juristas Estrella Gutiérrez David y Guillermo Lazcoz Moratinos, la dermatóloga Tania Díaz Corpas y la matemática y estadística Anabel Forte Deltell, quien nos ha ayudado a lograr que la primera visualización fuese lo más clara y precisa posible.

En relación con los distintos fototipos, hemos buscando evidencia sobre su distribución en España. Aunque un estudio publicado en 2020 en la revista Acta Dermato-Venereologica señalaba que lo habitual era que la población española se situase entre los fototipos II y III, hemos corroborado este extremo con distintos especialistas en dermatología, con los que también hemos contrastado qué grupos de población podrían incluirse tanto en los fototipos más bajos como en los fototipos más altos.

Sobre los catálogos de imágenes médicas en dermatología y la limitada anotación del tono de piel en las fotografías, hemos buscado evidencia en la literatura científica y, además de la revisión sistemática publicada en 2022 en The Lancet Digital Health, cuyos datos utilizamos para la tercera visualización, también nos apoyamos en esta otra revisión sistemática publicada en 2022 en la revista Journal of the American Academy of Dermatology, en esta revisión sistemática exploratoria (scoping review) publicada en 2021 en JAMA Dermatology y en este análisis publicado en 2022 en Proceedings of the ACM on Human Computer Interaction.

Para identificar los contratos públicos adjudicados a Transmural Biotech S.L. (B65084675), hicimos una búsqueda en la Plataforma de Contratos del Sector Público.

Sobre la primera visualización (sensibilidad y especificidad de los algoritmos):

Para crear una representación visual didáctica sobre los resultados de eficacia del algoritmo Quantus Skin al final de la pieza, hemos aproximado las distribuciones de probabilidad de ambas poblaciones (sana y enferma) mediante curvas gaussianas.

Para ello, a partir de los datos reales del estudio (55 casos de melanoma, de los cuales 38 resultaron ser verdaderos positivos y 17 falsos negativos; 177 casos sanos, de los que 142 fueron verdaderos negativos y 35 falsos positivos, con un umbral diagnóstico del 67,33%), se calcularon matemáticamente los parámetros de dos distribuciones normales que reprodujeran exactamente la sensibilidad (69,1%) y especificidad (80,2%) observadas.

Resultados del estudio de eficacia de Quantus Skin

Estas curvas, aunque simplificadas, permiten visualizar de manera intuitiva cómo el algoritmo distingue entre ambas poblaciones y cómo se generan los diferentes tipos de aciertos y errores diagnósticos (falsos positivos y falsos negativos) al aplicar el umbral diagnóstico e interactuar con él, mostrando de forma visual y sencilla el equilibrio existente entre ambas métricas.

Es importante destacar que estas representaciones gráficas son aproximaciones con fines puramente divulgativos.

Sobre la segunda visualización, relacionada con la infrarrepresentación de las pieles oscuras en el mayor catálogo de imágenes dermatológicas:

Para diseñar de forma didáctica la escala de Fitzpatrick (escala de color de los tonos de piel), nos hemos servido de los valores RGB de la tabla 1 publicada en 2017 en el libro [Cutaneous melanoma: Etiology and therapy](https://www.ncbi.nlm.nih.gov/books/NBK481860/) por Codon Publications.

La elección a modo de ejemplo de personalidades de los ámbitos deportivo y musical se ha contrastado con especialistas en dermatología. Los autores de las fotografías utilizadas son (CC BY-SA 3.0):

- Ed Sheeran: Harald Krichel

- Taylor Swift: iHeartRadioCA

- Rafael Nadal: Barcex

- Rosario Flores: Ayuntamiento de Fuenlabrada

- Salma Paralluelo: MichaelEmilio

- Nico Williams: Maider Goikoetxea

En la visualización, cada cuadrado equivale (aproximadamente) a 100 imágenes recogidas en el ISIC.

Sobre la tercera visualización, relacionada con el limitado registro del tono de piel en la mayoría de bases de datos médicas:

Cada grupo está formado por 10.695 círculos, de forma que cada uno representa a diez imágenes dermatológicas incluidas en la revisión sistemática publicada en The Lancet Digital Health. Los porcentajes utilizados en las visualizaciones se pueden encontrar en el sumario de la publicación. De las diferentes informaciones clínicas recogidas en la revisión sistemática hemos escogido las tres que nos parecían más relevantes y que encajaban mejor con la investigación.

Las 3 visualizaciones han sido desarrolladas con D3.js y Svelte.js.

Déjanos decirte algo…

En esta información, y en todo lo que puedes leer en Civio.es, ponemos todo el conocimiento acumulado de años investigando lo público, lo que nos afecta a todos y todas. Desde la sociedad civil, 100% independientes y sin ánimo de lucro. Sin escatimar en tiempo ni esfuerzo. Solo porque alguien tiene que hacerlo.

Si podemos informar así, y que cualquiera pueda acceder sin coste, sin barreras y sin anunciantes es porque detrás de Civio hay personas comprometidas con el periodismo útil, vigilante y al servicio de la sociedad en que creemos, y que nos gustaría seguir haciendo. Pero, para eso, necesitamos más personas comprometidas que nos lean. Necesitamos socios y socias. Únete hoy a un proyecto del que sentir orgullo.

Podrás deducirte hasta un 80% de tu aportación y cancelar cuando quieras.

¿Aún no es el momento? Apúntate a nuestro boletín gratuito.